每个研究者的数据都有自己的归档方法,所以使用别人的数据库其实没那么简单:每个研究者都有自己的研究领域和课题,不会专门为他人把数据以对方想要的方式整理好。

所以干活之前要思考几个问题,对于当前课题来说 a) 最重要的数据到底是什么,b) 以什么样的分析方法比较容易实现运算,c) 怎么样可以足够精确地引用到数据,又不会影响运算。

今年九月份的时候 赫尔辛基斯瓦希里语语料库1 发布了第二版(以下简称HCS2.0),版权是CC的(署名、非商业性使用、相同方式共享),说明页面,下载页面,再强调一下,版权所有者是 Arvi Hurskainen 教授和赫尔辛基大学。

新版里多了两个部分的档案,一部分是2009-2015坦桑尼亚(少量是肯尼亚)的报纸杂志档案,另一部分是2004-2006坦桑尼亚议会的会议记录。有点可惜的是,可能是由于版权问题,所以每篇文章的句子都随机打乱了顺序2,如果是研究上下文衔接的领域,这份语料库可能就没有太大的用处了。

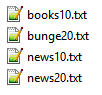

上面这幅图显示的是档案库的结构,HCS2.0使用了文件夹加文档(一篇文档一个文件)的结构,这种档案结构其实非常适合采用 AntConc 去做分析(定位关键词位置和相关的搭配),但是如果要对文件进行大规模的全文分析和写入操作时,这种档案结构就很麻烦了。

所以我想把一个文件夹里的所有文件组合到一个文件,但是依旧希望最早的档案被写入在这个文档的最前面。具体步骤是:

- 一个一个读取文件,分析metadata,生成新文件,以“年份-月份-日期”为文件名

- 根据日期一个一个读取文件,合并到一个文件里

最后的结果是:

- Helsinki Corpus of Swahili [↩]

- “The corpus text was randomly shuffled document-internally.” – Arvi Hurskainen [↩]